Znajdowanie i zarządzanie duplikatami w Excelu może być kluczowe dla utrzymania porządku w danych. Excel oferuje kilka prostych metod, które pozwalają szybko wykryć i usunąć powtarzające się informacje. Narzędzie "Usuń duplikaty", funkcja COUNTIF, warunkowe formatowanie czy filtracja to podstawowe sposoby radzenia sobie z tym problemem. Każda z tych metod ma swoje zastosowanie, w zależności od potrzeb użytkownika i charakteru danych.

Najważniejsze informacje:

- Narzędzie "Usuń duplikaty" pozwala szybko eliminować powtarzające się wiersze

- Funkcja COUNTIF umożliwia zliczenie wystąpień danej wartości

- Warunkowe formatowanie wizualnie wyróżnia duplikaty

- Filtracja pomaga w ukryciu powtarzających się danych

- Wybór metody zależy od konkretnych potrzeb i rodzaju danych

Dlaczego warto identyfikować duplikaty w Excelu?

Identyfikacja duplikatów w Excelu to kluczowy element utrzymania porządku i dokładności danych. Powtarzające się informacje mogą prowadzić do błędnych analiz i decyzji biznesowych. Skuteczne metody na wykrycie dubli w Excelu pozwalają na oczyszczenie arkuszy i zwiększenie efektywności pracy.

Regularne sprawdzanie i usuwanie duplikatów zapewnia integralność bazy danych. Czyste, unikalne rekordy ułatwiają zarządzanie informacjami i zwiększają wiarygodność raportów. Dodatkowo, eliminacja powtarzających się wierszy Excel może znacząco zmniejszyć rozmiar plików, przyspieszając ich działanie.

- Zapewnienie dokładności analiz i raportów

- Oszczędność miejsca na dysku i przyspieszenie działania arkuszy

- Ułatwienie zarządzania danymi i ich aktualizacji

- Zwiększenie efektywności pracy z dużymi zbiorami danych

Metoda 1: Używanie funkcji "Usuń duplikaty"

Funkcja "Usuń duplikaty" to wbudowane narzędzie Excela, które szybko i skutecznie eliminuje powtarzające się wiersze. To najprostsza metoda jak usunąć duplikaty w Excelu, idealna dla początkujących użytkowników. Narzędzie to pozwala na precyzyjne określenie, które kolumny mają być brane pod uwagę przy identyfikacji duplikatów.

- Zaznacz zakres danych, który chcesz przeanalizować

- Przejdź do zakładki "Dane" na górnym pasku narzędzi

- Kliknij przycisk "Usuń duplikaty"

- W oknie dialogowym zaznacz kolumny, które mają być uwzględnione

- Kliknij "OK", aby usunąć duplikaty

Główną zaletą tej metody jest jej szybkość i prostota użycia. Pozwala na błyskawiczne oczyszczenie danych bez konieczności tworzenia formuł. Jednak wadą może być brak możliwości podglądu duplikatów przed ich usunięciem. W przypadku dużych zbiorów danych, warto najpierw utworzyć kopię zapasową arkusza. Dodatkowo, ta metoda nie pozwala na zidentyfikowanie, które dokładnie rekordy były duplikatami.

Czytaj więcej: Jak zrobić ułamek w excelu - prosty sposób na wyświetlanie i obliczenia

Metoda 2: Wykorzystanie funkcji COUNTIF do znalezienia powtórzeń

Funkcja COUNTIF to potężne narzędzie do znalezienia powtórzonych wartości w arkuszu. Zlicza ona wystąpienia określonej wartości w wybranym zakresie. Jest szczególnie przydatna, gdy chcemy zidentyfikować duplikaty bez ich automatycznego usuwania.

Przykładowa formuła: =COUNTIF($A$2:$A$100,A2) - wpisana w kolumnie B, zaczynając od B2, zlicza wystąpienia wartości z A2 w zakresie A2:A100. Wynik większy niż 1 oznacza duplikat.

Zaletą tej metody jest możliwość dokładnego zliczenia wystąpień każdej wartości. Pozwala na selektywne usuwanie duplikatów i zachowanie kontroli nad procesem. Wadą może być konieczność manualnego analizowania wyników i usuwania duplikatów. Dla dużych zbiorów danych proces ten może być czasochłonny. Dodatkowo, wymaga od użytkownika podstawowej znajomości formuł Excela.

Metoda 3: Warunkowe formatowanie do wizualnej identyfikacji duplikatów

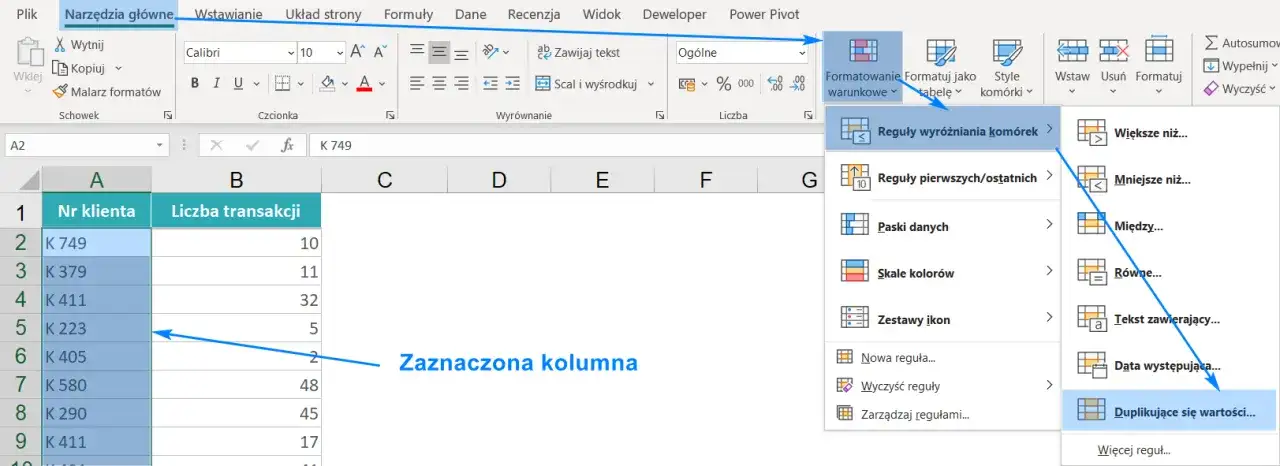

Warunkowe formatowanie to świetne narzędzie do identyfikacji zduplikowanych danych Excel poprzez ich wizualne wyróżnienie. Umożliwia szybkie zlokalizowanie powtarzających się wartości bez konieczności ich usuwania. Ta metoda jest szczególnie przydatna, gdy chcemy zachować duplikaty, ale potrzebujemy je łatwo zidentyfikować.

- Zaznacz zakres danych do analizy

- Przejdź do zakładki "Strona główna" i kliknij "Formatowanie warunkowe"

- Wybierz "Reguły wyróżniania komórek" > "Duplikuj wartości"

- Wybierz sposób formatowania duplikatów i zatwierdź

Główną zaletą tej metody jest możliwość szybkiej wizualnej identyfikacji duplikatów bez ich usuwania. Pozwala na łatwe dostrzeżenie wzorców w danych. Wadą może być trudność w pracy z bardzo dużymi zbiorami danych, gdzie kolorowe wyróżnienia mogą być przytłaczające. Dodatkowo, metoda ta nie usuwa automatycznie duplikatów, co może wymagać dodatkowej pracy manualnej w przypadku konieczności ich eliminacji.

Metoda 4: Filtrowanie danych w poszukiwaniu duplikatów

Filtrowanie to prosta, ale skuteczna metoda na wykrycie dubli w Excelu. Pozwala na szybkie sortowanie i grupowanie danych, co ułatwia identyfikację powtórzeń. Ta technika jest szczególnie przydatna, gdy chcemy zachować kontrolę nad procesem i selektywnie usuwać lub modyfikować duplikaty.

- Zaznacz zakres danych i włącz filtrowanie (zakładka "Dane" > "Filtr")

- Kliknij strzałkę w nagłówku kolumny, którą chcesz przeanalizować

- Wybierz "Filtruj według koloru" > "Filtruj według duplikatów"

- Przejrzyj i zmodyfikuj lub usuń znalezione duplikaty

Zaletą tej metody jest możliwość selektywnego przeglądania i zarządzania duplikatami. Daje pełną kontrolę nad procesem i pozwala na analizę kontekstu każdego powtórzenia. Wadą może być czasochłonność przy dużych zbiorach danych. Wymaga również manualnego usuwania lub modyfikacji znalezionych duplikatów. Dodatkowo, metoda ta może być mniej efektywna przy bardzo skomplikowanych zestawach danych z wieloma kolumnami.

Która metoda jest najlepsza? Porównanie technik

| Metoda | Szybkość | Dokładność | Łatwość użycia |

|---|---|---|---|

| Usuń duplikaty | Bardzo wysoka | Wysoka | Bardzo łatwa |

| COUNTIF | Średnia | Bardzo wysoka | Średnia |

| Warunkowe formatowanie | Wysoka | Wysoka | Łatwa |

| Filtrowanie | Średnia | Wysoka | Łatwa |

Analizując tabelę, widać, że każda metoda ma swoje mocne strony. "Usuń duplikaty" wyróżnia się szybkością i łatwością użycia, idealna dla prostych zadań. COUNTIF oferuje najwyższą dokładność, ale wymaga więcej umiejętności. Warunkowe formatowanie balansuje między łatwością a efektywnością. Filtrowanie daje największą kontrolę, ale może być czasochłonne przy dużych zbiorach danych.

Co zrobić po znalezieniu duplikatów?

- Usunąć zbędne powtórzenia

- Scalić informacje z duplikatów

- Oznaczyć duplikaty do dalszej analizy

- Utworzyć raport z podsumowaniem znalezionych duplikatów

- Zarchiwizować oryginalne dane przed modyfikacją

Usuwanie zbędnych powtórzeń to najprostsze rozwiązanie, ale warto upewnić się, że nie tracimy cennych informacji. Scalanie informacji z duplikatów może być korzystne, gdy każdy rekord zawiera unikalne, uzupełniające się dane.

Oznaczanie duplikatów do dalszej analizy jest przydatne, gdy potrzebujemy głębszego zrozumienia przyczyn ich powstawania. Tworzenie raportu z podsumowaniem znalezionych duplikatów pomoże w dokumentacji procesu i może być cenne dla przyszłych analiz.

Archiwizacja oryginalnych danych przed modyfikacją to kluczowy krok bezpieczeństwa. Pozwala na powrót do pierwotnego stanu w razie potrzeby lub błędu w procesie czyszczenia danych.

Wybór odpowiedniej akcji zależy od kontekstu i celu analizy danych. Warto rozważyć każdą opcję pod kątem potrzeb projektu i potencjalnych konsekwencji.

Jak zapobiegać powstawaniu duplikatów w przyszłości?

Implementacja unikalnych identyfikatorów dla każdego rekordu to skuteczna metoda zapobiegania duplikatom. Możesz użyć funkcji CONCATENATE do stworzenia unikalnego klucza łączącego kilka pól, lub skorzystać z automatycznie generowanych identyfikatorów. Ta technika znacząco zmniejsza ryzyko wprowadzenia identycznych rekordów.

Regularne audyty i czyszczenie danych powinny stać się częścią rutyny pracy z arkuszami. Ustaw przypomnienia o okresowym sprawdzaniu duplikatów, na przykład raz w tygodniu lub miesiącu, w zależności od intensywności wprowadzania nowych danych. Systematyczne podejście pomoże utrzymać bazę danych w czystości i zapobiegnie nagromadzeniu się problemów.

Szkolenie zespołu w zakresie prawidłowego wprowadzania danych jest kluczowe dla minimalizacji błędów ludzkich. Opracuj jasne wytyczne dotyczące formatowania danych, używania wielkich liter czy standardowych skrótów. Regularne warsztaty i przypomnienia o najlepszych praktykach pomogą zespołowi konsekwentnie stosować się do ustalonych zasad, redukując ryzyko tworzenia duplikatów.

Zawsze twórz kopię zapasową arkusza przed rozpoczęciem procesu usuwania duplikatów. To zabezpieczy Cię przed przypadkową utratą ważnych danych. Aby utworzyć kopię, po prostu kliknij prawym przyciskiem myszy na nazwę arkusza i wybierz "Przenieś lub kopiuj", zaznaczając opcję "Utwórz kopię".

Zaawansowane techniki zarządzania duplikatami w dużych zbiorach danych

Zarządzanie duplikatami w dużych zbiorach danych wymaga bardziej zaawansowanych technik. Tradycyjne metody mogą okazać się niewystarczające lub zbyt wolne przy pracy z setkami tysięcy rekordów. W takich przypadkach konieczne jest zastosowanie bardziej wyrafinowanych narzędzi i podejść.

Power Query to potężne narzędzie dostępne w nowszych wersjach Excela, idealne do pracy z dużymi zbiorami danych. Umożliwia ono efektywne wyszukiwanie duplikatów Excel poprzez zaawansowane transformacje danych. Power Query pozwala na łatwe łączenie, przekształcanie i czyszczenie danych z różnych źródeł, co jest szczególnie przydatne przy kompleksowych analizach. Dodatkowo, operacje wykonywane w Power Query są zazwyczaj szybsze niż tradycyjne formuły Excela, co jest kluczowe przy pracy z ogromnymi arkuszami.

Indeksowanie i haszowanie to zaawansowane techniki programistyczne, które można wykorzystać do szybkiej identyfikacji zduplikowanych danych Excel. Tworzenie unikalnych haszy dla każdego rekordu pozwala na błyskawiczne porównywanie i identyfikację duplikatów, nawet w bardzo dużych zbiorach danych. Ta metoda wymaga użycia VBA lub zewnętrznych narzędzi programistycznych, ale oferuje niezrównaną wydajność przy pracy z milionami rekordów. Zastosowanie indeksów i haszy może znacząco przyspieszyć proces wyszukiwania i eliminacji duplikatów, szczególnie w przypadku skomplikowanych zestawów danych z wieloma kolumnami.

Wykorzystanie makr VBA do automatyzacji procesu

Makra VBA (Visual Basic for Applications) oferują potężne możliwości automatyzacji procesów wyszukiwania duplikatów Excel. Pozwalają na stworzenie niestandardowych, złożonych algorytmów dostosowanych do specyficznych potrzeb danego zbioru danych. Dzięki VBA możesz zautomatyzować cały proces od identyfikacji po usuwanie duplikatów, co jest nieocenione przy regularnej pracy z dużymi zbior ami danych.

Oto przykładowe kroki, które może wykonywać makro VBA do automatyzacji procesu wyszukiwania i usuwania duplikatów:

- Skanowanie określonego zakresu danych w poszukiwaniu duplikatów

- Tworzenie unikalnego identyfikatora dla każdego rekordu

- Porównywanie identyfikatorów w celu wykrycia powtórzeń

- Oznaczanie lub przenoszenie znalezionych duplikatów do osobnego arkusza

- Generowanie raportu z podsumowaniem znalezionych i usuniętych duplikatów

Najczęstsze błędy przy wyszukiwaniu duplikatów - czego unikać?

- Ignorowanie różnic w formatowaniu danych

- Pomijanie pustych komórek

- Nieuwzględnianie wszystkich istotnych kolumn

- Brak kopii zapasowej przed usuwaniem duplikatów

- Automatyczne usuwanie wszystkich znalezionych duplikatów bez weryfikacji

Różnice w formatowaniu mogą prowadzić do przeoczenia faktycznych duplikatów. Zawsze standaryzuj dane przed rozpoczęciem wyszukiwania. Puste komórki często są ignorowane przez narzędzia do wyszukiwania duplikatów, co może prowadzić do niepełnych wyników. Upewnij się, że Twoja metoda uwzględnia również puste pola.

Nieuwzględnienie wszystkich istotnych kolumn może skutkować błędną identyfikacją duplikatów. Dokładnie przeanalizuj strukturę danych i określ, które kolumny są kluczowe dla identyfikacji unikalnych rekordów. Brak kopii zapasowej to ryzyko utraty ważnych danych. Zawsze twórz backup przed rozpoczęciem procesu usuwania duplikatów.

Automatyczne usuwanie wszystkich znalezionych duplikatów bez weryfikacji może prowadzić do utraty cennych informacji. Zawsze przeglądaj znalezione duplikaty przed ich usunięciem, aby upewnić się, że nie tracisz ważnych danych. W niektórych przypadkach duplikaty mogą zawierać uzupełniające się informacje, które warto zachować lub scalić.

Jak znaleźć powtarzające się dane w Excelu to kluczowa umiejętność dla każdego, kto pracuje z dużymi zbiorami danych. Stosując opisane metody i unikając typowych błędów, możesz skutecznie zarządzać duplikatami, poprawiając jakość i wiarygodność swoich analiz. Pamiętaj, że wybór odpowiedniej metody zależy od specyfiki Twoich danych i celu analizy. Regularne praktykowanie tych technik pomoże Ci stać się ekspertem w eliminacji powtarzających się wierszy Excel.

Efektywne zarządzanie danymi: Klucz do sukcesu w analizie arkuszy Excel

Wykrywanie i usuwanie duplikatów w Excelu to nie tylko kwestia porządku, ale przede wszystkim gwarancja dokładności analiz i podejmowanych decyzji biznesowych. Poznanie różnych metod, od prostego narzędzia "Usuń duplikaty" po zaawansowane techniki z wykorzystaniem VBA, pozwala na elastyczne podejście do różnorodnych zestawów danych.

Kluczowe jest zrozumienie, że każda metoda ma swoje zalety i ograniczenia. Wybór odpowiedniej techniki zależy od wielkości danych, częstotliwości aktualizacji i specyfiki projektu. Pamiętaj, że identyfikacja zduplikowanych danych Excel to nie tylko jednorazowe działanie, ale ciągły proces utrzymania jakości danych.

Wdrożenie regularnych praktyk zapobiegania duplikatom, takich jak stosowanie unikalnych identyfikatorów czy szkolenie zespołu, może znacząco zmniejszyć potrzebę częstego czyszczenia danych. Ostatecznie, umiejętność skutecznego zarządzania duplikatami przekłada się na zwiększoną efektywność pracy, oszczędność czasu i poprawę jakości analiz, co jest nieocenione w dynamicznym środowisku biznesowym.